Beschreibung

Definition von Token

Token sind ein zentraler Baustein in der Textverarbeitung von maschinellen Lernmodellen wie OpenAI’s ChatGPT und bilden die Grundlage für das Verständnis und die Interpretation von Textdaten. Diese Elemente, auch als Token bezeichnet, sind die kleinsten Einheiten, die solche Modelle verarbeiten können.

In der einfachsten Form kann ein Token ein einzelnes Wort, ein Satzzeichen oder ein Leerzeichen darstellen. Komplexere Modelle wie ChatGPT erweitern dieses Konzept jedoch und können Token auch als Teile eines Wortes oder sogar mehrere Wörter definieren. Dieser Ansatz wird als Subword-Tokenisierung bezeichnet.

Wie Token berechnet werden

Bei der Verarbeitung eines Textes wird dieser zunächst in eine Reihe von Token zerlegt. Dieser Vorgang wird Tokenisierung genannt. Das Modell verwendet dann die repräsentativen Zahlenwerte dieser Token zur Analyse und Vorhersage des Textes.

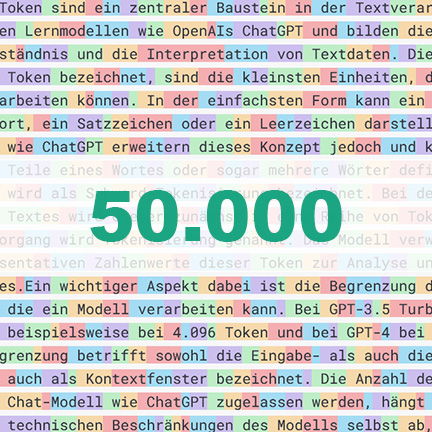

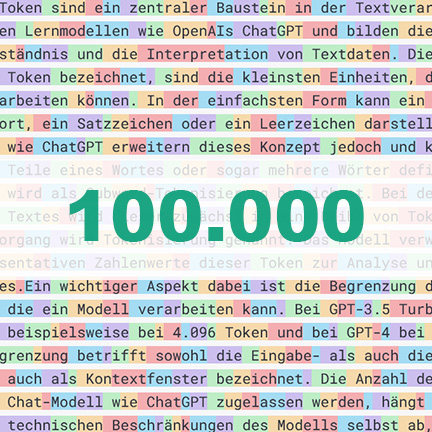

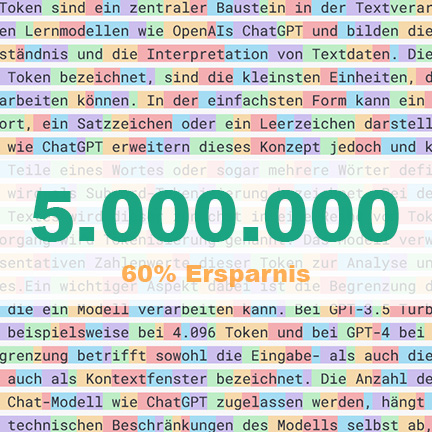

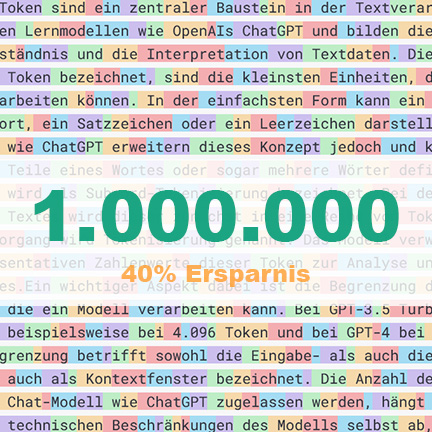

Ein wichtiger Aspekt dabei ist die Begrenzung der Anzahl der Token, die ein Modell verarbeiten kann. Bei GPT-3.5 Turbo liegt diese Grenze beispielsweise bei 4.096 Token und bei GPT-4 bei 8.192 Token. Diese Begrenzung betrifft sowohl die Eingabe- als auch die Ausgabetexte und wird auch als Kontextfenster bezeichnet. Die Anzahl der Token, die in einem Chat-Modell wie ChatGPT zugelassen werden, hängt nicht nur von den technischen Beschränkungen des Modells selbst ab, sondern kann auch vom Betreiber des Chats oder der spezifischen Anwendung festgelegt werden.

Bewertungen

Es gibt noch keine Bewertungen.